HISTORIA DE LAS COMPUTADORAS

La computadora es un invento de gran impacto en la historia, para saber su origen es necesario saber ¿qué es una computadora?

|

| 500 a.C |

|

| 1642 |

fue la primera calculadora que se inventó en el mundo, era una maquina mecánica que solo podía hacer sumas y restas, esta era funcionaba por medio de una serie de ruedas y de diferentes engranajes. En 1670 el filósofo y matemático alemán Gottfried Leibniz trabajó en el perfeccionamiento de la máquina de suma de Pascal, e intentó mejorarla de forma que fuera capaz de multiplicar y dividir.

|

| 1820 |

Aritmómetro (Arithmometer en inglés) o calculadora mecánica fue la evolución de la máquina calculadora construida por Gottfried Leibniz en el año 1694, que se basaba en la rueda de Leibniz. Es considerado uno de los mejores inventos de la época mecánica. Esta máquina era capaz, a diferencia de las anteriores, de realizar las cuatro operaciones básicas (sumar, restar, multiplicar y dividir) de manera sencilla, con resultados de hasta 12 cifras. El aritmómetro, inventado por Charles Xavier Thomas de Colmar en 1820, fue la primera máquina de calcular comercialmente exitosa capaz de realizar sumas, restas, multiplicaciones y divisiones.

El primer intento de Charles Babbage para diseñar una máquina fue la Máquina diferencial, que fue un computador diseñado específicamente para construir tablas de Logaritmos y de funciones trigonométricas evaluando Polinomios por aproximación.

Si bien este proyecto no vio la luz por razones económicas y personales, Babbage comprendió que parte de su trabajo podía ser aprovechado en el diseño de un computador de propósito general, de manera que inició el diseño de la máquina analítica.

máquina tabuladora el estadounidense Herman Hollerith inventa una máquina tabuladora aprovechando algunas de las ideas de Babbage,

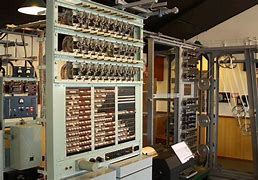

La Z1

|

| 1944 |

Mark I en Estados Unidos la empresa IBM construye la computadora electromecánica Harvard Mark I, diseñada por un equipo encabezado por Howard H. Aiken. Fue la primera computadora creada en Estados Unidos.

Harvard Mark I o Mark I, fue el primer ordenador electromecánico, se basaba en la máquina analítica de Charles Babbage.

Las máquinas Colossus

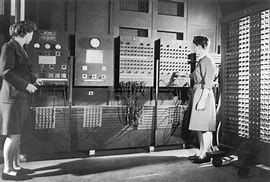

fueron los primeros dispositivos calculadores electrónicos usados por los británicos para leer las comunicaciones cifradas alemanas durante la Segunda Guerra Mundial. Colossus fue uno de los primeros computadores digitales. Las máquinas Colossus se usaron para descifrar los mensajes cifrados, que se interceptaban de las comunicaciones de la Alemania nazi, usando la máquina Lorenz SZ40/42. Colossus comparaba dos flujos de datos, contando cada coincidencia basada en una función programable booleana. El mensaje cifrado se leía a gran velocidad a través de una cinta de papel. El otro flujo de datos era generado internamente, y era una simulación electrónica de la máquina de Lorenz en varias combinaciones.El ENIAC fue el primer ordenador de propósito general, es decir, podía programarse para realizar diferentes tareas. En aquella época aún no se había inventado el chip, así que los ordenadores funcionaban con válvulas o tubos de vacío, unas cápsulas de cristal del tamaño de una mano. Por eso ocupaban tanto.

Transistor

en los Laboratorios Bell, John Bardeen, Walter HouserBrattain y William Shockley inventan el transistor. El transistor es un dispositivo electrónico semiconductor. Permite el paso de una señal en respuesta a otra. Se puede configurar o "comportar" como amplificador, oscilador, conmutador o rectificador. Se encuentra prácticamente en todos los aparatos electrónicos como radios, televisores y computadoras. Habitualmente dentro de los llamados circuitos integrados.

El IBM 650 IBM fabrica su primera computadora a escala industrial, la IBM 650. Se amplía el uso del lenguaje ensamblador para la programación de las computadoras. Las computadoras con transistores reemplazan a las de válvulas, marcando el comienzo de la segunda generación de computadoras.

fue uno de los primeros ordenadores de IBM, y el primero que fue fabricado a gran escala. Fue anunciado en 1953, y se produjeron 2000 unidades desde 1954 (la primera venta) hasta 1962. En 1969, IBM dejó de dar servicio técnico para el 650 y sus componentes. El 650 es una máquina que codifica tanto datos como direcciones de memoria en sistema decimal, guardando cada cifra en código binario. Este código guarda, mediante varios bits, dos variables: una con 2 posibles estados, y otra con 5 posibles estados.

Microprocesador intel 4004 Intel presenta el primer microprocesador comercial, el primer chip: el microprocesador Intel 4004, diseñado por Federico Faggin, Marcian Hoff y Masatoshi Shima. Es el encargado de ejecutar todos los programas, desde el sistema operativo hasta las aplicaciones de usuario; solo ejecuta instrucciones en lenguaje máquina, realizando operaciones aritméticas y lógicas simples, tales como sumar, restar, multiplicar, dividir y las operaciones bitwise, también las lógicas binarias y accesos a memoria.

1975: Bill Gates y Paul Allen fundan Microsoft.

1976: Steve Jobs, Steve Wozniak, Mike Markkula fundan Apple.

Apple II

fue la primera serie de microcomputadoras de producción masiva hecha por la empresa Apple Computer entre el 5 de junio de 1977 y mediados de los años 1980. El Apple II tenía una arquitectura de 8 bits basada en el procesador 6502. Era completamente diferente de los posteriores modelos Macintosh de Apple. Su antecesor fue el Apple I, una máquina construida a mano y vendida a los aficionados.

ARPANET fue una red de computadoras creada por encargo del Departamento de Defensa de los Estados Unidos (DOD) para utilizarla como medio de comunicación entre las diferentes instituciones académicas y estatales. El primer nodo se creó en la Universidad de California en Los Ángeles (UCLA) y fue la espina dorsal de Internet hasta 1990, tras finalizar la transición al modelo de protocolos TCP/IP, iniciada en 1983.

- Usaban tubos de vacío.

- Usaban tarjetas perforadas.

- Guardaban datos en cilindros magnéticos.

- realizaban operaciones básicas (suma, resta, multiplicación, división).

- Usaban lenguaje de máquina (conjunto de

códigos binarios).

- Generaban mucho calor.

- eran lentas.

- eran muy grandes.

- Incursionan los transistores.

- usaban pequeños anillos magnéticos para almacenar.

- se usan lenguajes de programación FORTRAN y COBOL.

- no se calentaban tanto.

- mejoraron su velocidad.

- redujeron su tamaño.

- se emplean circuitos integrados.

- guardaban datos en chips.

- realizaban operaciones matemáticas aritmeticológicas.

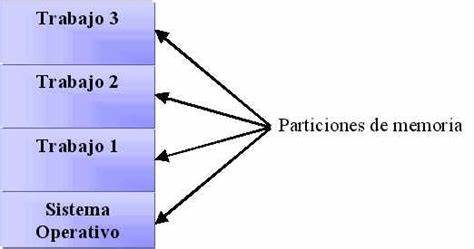

- utilizaban multiprogramación.

- Calentaban poco.

- ejecutaban varios programas al mismo tiempo.

- el tamaño era mini.

- Aparece el microprocesador y el LSI.

- la memoria de ahora es de chips en silicio.

- surgen las super computadoras o PC (computadora personal).

- usan lenguaje PROLOG, C++, SMALTALK, etc.

- Cada chip puede hacer diferentes tareas.

- cuenta con unidad aritmeticológica.

- se volvieron más comerciales.

- Los componentes son de alta capacidad.

- El software evoluciona, se desarrolla la inteligencia artificial.

- surgen las laptops.

- se usan lenguajes naturales y algoritmos.

- se da el manejo de multimedia y surgimiento de la web.

- Son capaces de mantener millones de procesos.

- pueden realizar casi cualquier tarea.

- son portátiles.

Comentarios

Publicar un comentario